🥚 1.1 Basiskennis AI: Toen & 🐣 Nu

welkom bij de eerste les van prompten voor proffies

Goed dat je er bent!!

prompten voor proffies is een praktische cursus effectief werken met AI gebaseerd op de legendarische 'monkey see, monkey do-methode' (zelf verzonnen)

Geen eindeloze theorie of abstracte concepten, maar concrete voorbeelden uit de praktijk met échte resultaten en duidelijke instructies hoe je deze zelf kunt behalen.

Elke les is opgezet om kennis, tools en werkwijzes zo efficient mogelijk over te brengen. Ik laat zien hoe iets voor mijn doel(en) werkt en laat jou hetzelfde doen voor jouw doel(en). "Minder praten, meer doen" zei het motto.

"Minder praten, meer doen"

het motto

Echter, om een goed begin te kunnen maken heb je solide basiskennis nodig. Daarom behandelen we in de eerste module een aantal belangrijke zaken waar je iedere keer te maken mee krijgt als je intensief bezig bent met AI.

Aan het einde van deze module kun je zelfverzekerd keuzes maken (en beargumenteren) als het gaat om:

- het kiezen van het juiste model;

- het kiezen van de juiste app;

- het kiezen/maken van de juiste (eerste) prompts.

een goed begin..

Thinking..

.. is het 0.3849382 werk 💯

Juist! Een goed begin, ongeacht de plek waar je iets uitvoert. Met deze kennis onder de knie kun je met een gerust hart druk maken om het echte werk. Maar voor nu beginnen we eerst met een stukje.. geschiedenis 🤓.

het is zo voorbij!

Beloofd 🥹

🎓 Waarom deze les?

AI groeit supersnel en dat maakt het moeilijk om alles continu bij te houden. Elke week komen er wel nieuwe updates uit. Nieuwe modellen, nieuwe apps en nieuwe bedrijven. Wat vorige maand nog spectaculair-top-of-the-top-baanbrekende-innovatie was, is met grote kans nu alweer normaalste zaak op de wereld.

Je ziet geen bomen en bossen meer.

sorry, oud modelletje.. 🤦

Het gaat soms te snel en dat is vervelend, maar ook mooi natuurlijk. De AI-revolutie is aan de gang en wij mogen het allemaal meemaken. Neemt niet weg dat het overweldigend kan zijn en je het gevoel kan krijgen dat je voortdurend achterloopt (FOMO). In deze les gaan we proberen daar enigszins iets aan doen!

Macht is kennis!

😭

Hoe meer je weet, hoe beter je dalijk kunt inschatten welk model, welke app en welke nieuwsberichten voor jou relevant zijn. Dat zorgt voor minder ruis en een effectieve leerstrategie. In deze les gaan we daarom beginnen, bij het begin.

ben je d'r klaar voor? let me take you back.. way back..

Back into time.. 🤩

🧠 Darthmouth Workshop

Meer dan 70 jaar geleden kwam een stel wetenschappers bij elkaar om een superlange hackaton te organiseren genaamd de Darthmouth Workshop. Ze hadden een simpele vraagstelling bedacht:

"Kunnen we machines net zo slim maken als mensen?"

Vol goede moed begonnen ze aan een lange brainstormsessie. De hackaton duurde zo’n acht weken. Er waren elf mensen uitgenodigd en hoewel niet iedereen de hele tijd aanwezig was kwamen er continu verschillende mensen langs die bijdroegen aan de gesprekken. Dit zorgde voor een consistente stroom frisse inzichten en genoeg tijd om elk idee goed onder de loep te nemen.

Deze aanpak was cruciaal voor het succes. Iedereen kon een paar dagen nadenken en dan weer terugkomen met nieuwe inzichten.

💡 Klik hier voor wat voorbeelden van hoe dat er in de praktijk uit zag (klapt uit)

- Bekende AI-influencer van die tijd en tevens hoofdorganisator van de hackathon John McCarthy presenteerde in de eerste week zijn ideeën over symbolische logica. Dit is een soort programmeren dat tekens zoals letters en cijfers gebruikt om dingen logisch te kunnen zeggen en opschrijven.

- Allen Newell en Herbert Simon kwamen in week twee met een vroege versie van hun "Logic Theorist" programma. Het allereerste programma dat zelf kon "nadenken" en problemen op kon lossen.

- Marvin Minsky sloot zich aan in week drie met zijn theorieën over (kunstmatige) neurale netwerken. Een manier om de werking van ons menselijk brein na te bootsen. Dit botste enigszins met John McCarthy's ideeëen over symbolische logica, maar in plaats van dat dit tot conflict leidde onstonden er mooie discussies over de verschillende wegen naar intelligentie.

- Claude Shannon verscheen in week vijf met zijn informatietheorie die beschrijft hoe je informatie zoals woorden, plaatjes of geluiden het beste om kan zetten naar een vorm die machines goed kunnen begrijpen en versturen.

- De week erna kwamen Allen Newell en Herbert Simon weer terug met een nieuwe versie van hun programma, waarin zij alle feedback van de andere deelnemers hadden verwerkt. Een mooi voorbeeld van de effectiviteit van de aanpak van de hackathon.

Acht weken vlogen voorbij en ondanks de vruchtbare periode had het brainstormen uiteindelijk niet de doorbraak gebracht waar iedereen op gehoopt had, maar ze hadden wel iets anders legendarisch bereikt!

legendarisch.. oeh..

drum rolls please..

👇🫡

"Artifical Intelligence"

John McCarthy

John McCarty gaf het als eerste een naam. Vanaf dat moment kon men officieel onderzoek doen naar de wondere wereld van "Kunstmatige Intelligentie". Veel mensen beschouwen dit moment als het officiële startpunt van AI.

Aan het einde is er een plan van aanpak opgesteld met verschillende onderzoeksrichtingen. Sommigen richtten zich op patroonherkenning, anderen op logisch redeneren en weer anderen werkten aan het begrijpen van taal. Verschillende stukjes van dezelfde grote AI puzzel die ze samen hoopten in elkaar te zetten. De hackaton zorgde voor veel enthousiasme over de potentie van AI.

🎉 De AIfterparty

In de jaren die volgden werd er veel tijd en geld gestoken in onderzoek. Veel overheden en universiteiten geloofden dat kunstmatige intelligentie om de hoek lag. Geschat werd binnen 10 jaar machines te kunnen bouwen die net zo slim als mensen zouden zijn, dat bleek wat optimistisch. Niet omdat de ideeën niet goed waren, maar omdat computers toen simpelweg nog niet krachtig genoeg waren om ze uit te voeren.

De eerste systemen konden simpele spelletjes spelen en makkelijke puzzels oplossen, maar zodra de problemen iets moeilijker werden liepen ze vast. Rond de jaren zeventig kwam de eerste zogenaamde "AI winter". De verwachtingen waren niet waargemaakt en het geld raakte op. Onderzoekers moesten hun grote plannen voorlopig parkeren en zich richten op kleinere, meer afgebakende problemen, zoals het herkennen van geschreven tekst of het oplossen van complexe schaakscenario's.

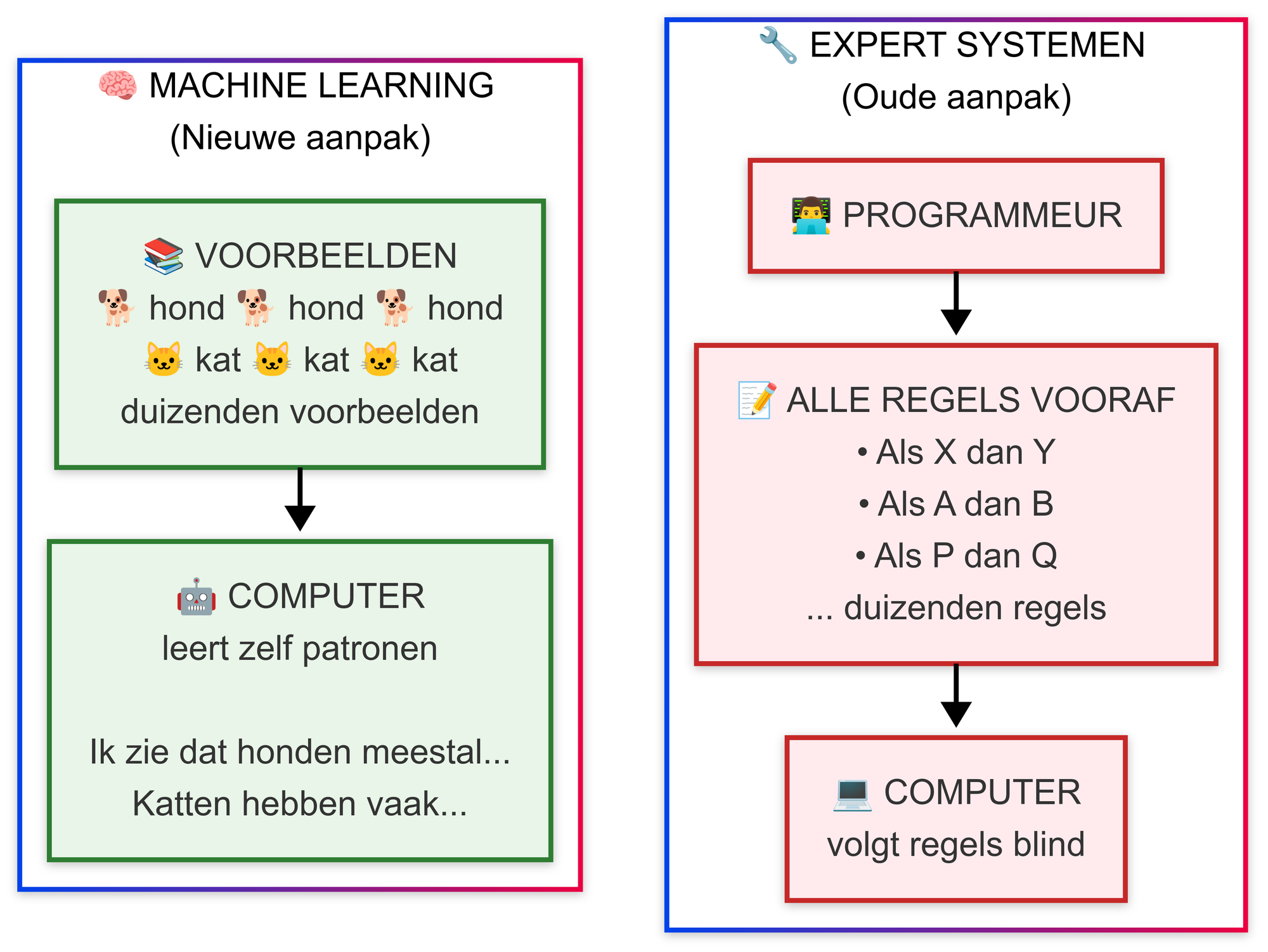

In de jaren tachtig kwam er een opleving dankzij de opkomst van expert systemen. Dit waren programma's die zijn ontwikkeld met de kennis van experts om beslissingen te nemen. Ze werden vooral gebruikt voor medische diagnoses en technische storingen, maar ook deze ontwikkeling stuitte uiteindelijk op bepaalde grenzen. Ze konden niet omgaan met nieuwe inzichten of onvoorziene situaties, omdat deze nog niet geprogrammeerd waren. Dit maakte de systemen moeilijk onderhoudbaar en uiteindelijk uiterst onbetrouwbaar voor serieuze vraagstukken.

dus stel je voor je bouwt een systeem dat alles weet over auto-reparaties. maar dan komt er een nieuwe auto op de markt met een technologie dat nog niet bestond toen je het systeem maakte

Dan staat het systeem met lege handen. Het kan alleen werken met wat er van tevoren is ingeprogrammeerd. Geen flexibiliteit, geen aanpassingsvermogen.

precies! en dat was het probleem met die expert systemen uit de jaren tachtig. ze werkten prima met oude kennis, maar zodra er iets nieuws gebeurde waren ze nutteloos

🤖 Machine Learning

Door de teleurstellingen van de expert systemen begonnen de onderzoekers anders na te denken over intelligentie. In plaats van alle kennis vooraf te programmeren vroegen zich af of computers zichzelf konden laten leren doormiddel van voorbeelden en patroonherkenning. Dit was het begin van wat we nu machine learning noemen.

Men dacht een klein kind leert ook niet door duizenden regels te onthouden. Het ziet voorbeelden en leert op basis daarvan patronen te herkennen. Een hond is een hond, omdat een kind veel honden heeft gezien en de overeenkomsten heeft opgemerkt.

De eerste machine learning systemen waren vrij simpel. Ze konden bijvoorbeeld handgeschreven cijfers herkennen door duizenden voorbeelden van handgeschreven cijfers te analyseren. Het systeem leerde zelf welke kenmerken belangrijk waren.

is er een ronding aan de bovenkant? dan is het waarschijnlijk een 6, 8, 9 of 0

Heeft het twee verticale lijnen? Dan is het waarschijnlijk een 11.

Of niet.. 🤔

Het ontdekte zelf welke details belangrijk waren door voorbeelden te vergelijken in plaats van dat een programmeur dit van tevoren moet bedenken.

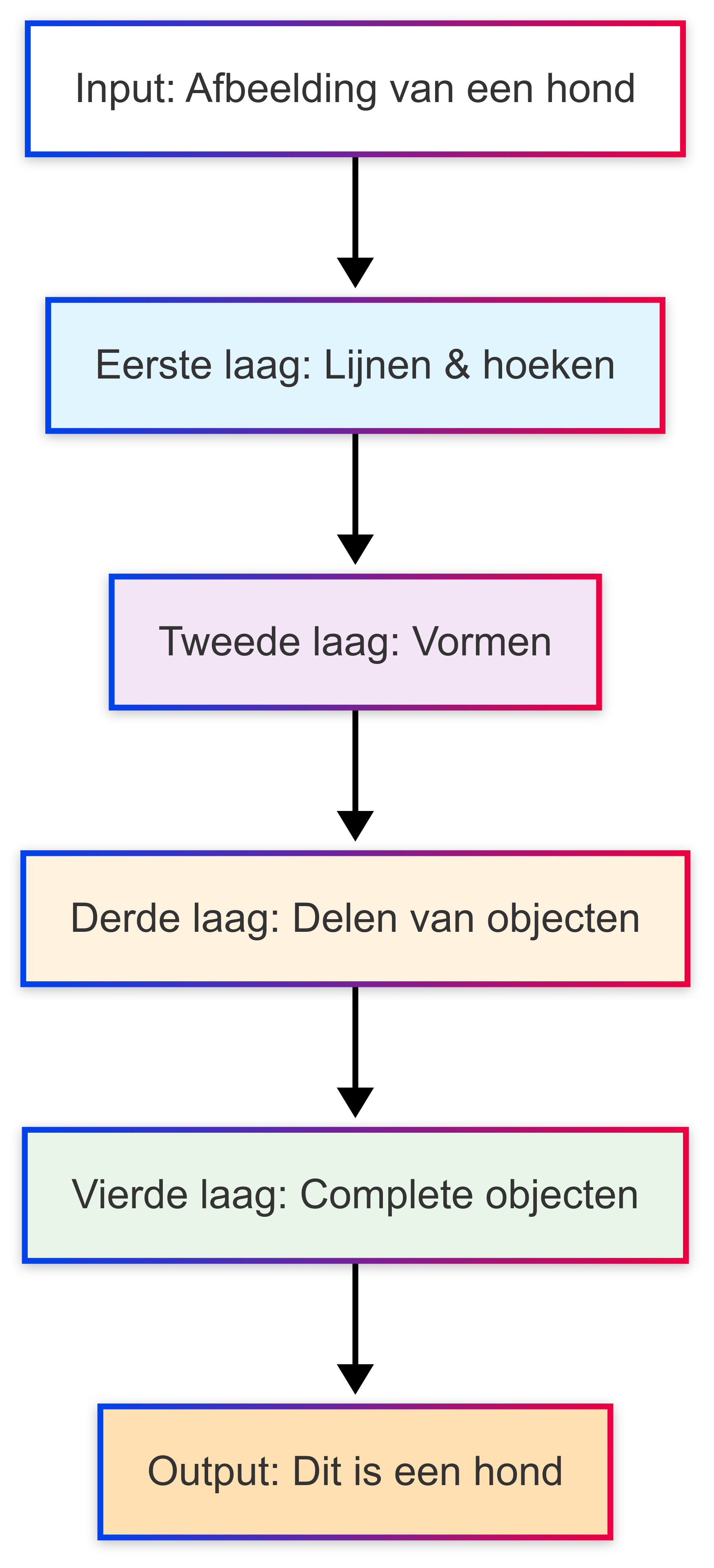

🕸️ Neurale Netwerken

Terwijl machine learning zich ontwikkelde werkten andere onderzoekers aan neurale netwerken. Ze probeerden kunstmatige neuronen met elkaar te verbinden om zo het menselijk brein na te bootsen. De eerste neurale netwerken waren klein en konden alleen simpele taken aan, maar toen ontdekten ze dat deze netwerken effectiever werden als je ze in lagen stapelde. De eerste laag zag misschien alleen lijnen en hoeken, maar de volgende combineerde dit tot vormen en zo ontstond er op een gegeven moment een stapel lagen (neuraal netwerk) dat complete objecten kon herkennen.

leuk weetje tussendoor.. binnen de kunst van het prompten heb ik eenzelfde soort concept bedacht genaamd "Prompt Stapelen"

Prompts met andere prompts. Wij noemen het promptception. Zorgt er vaak voor dat we precies goed uitgelegd krijgen wat de bedoeling is.

Superchill..

oké nou wij noemen het ook wel "Tosti Prompts". lekker veel ingredienten bij elkaar gooien en hopen dat het smaakt. heerlijk

Jongens.. FOCUS!

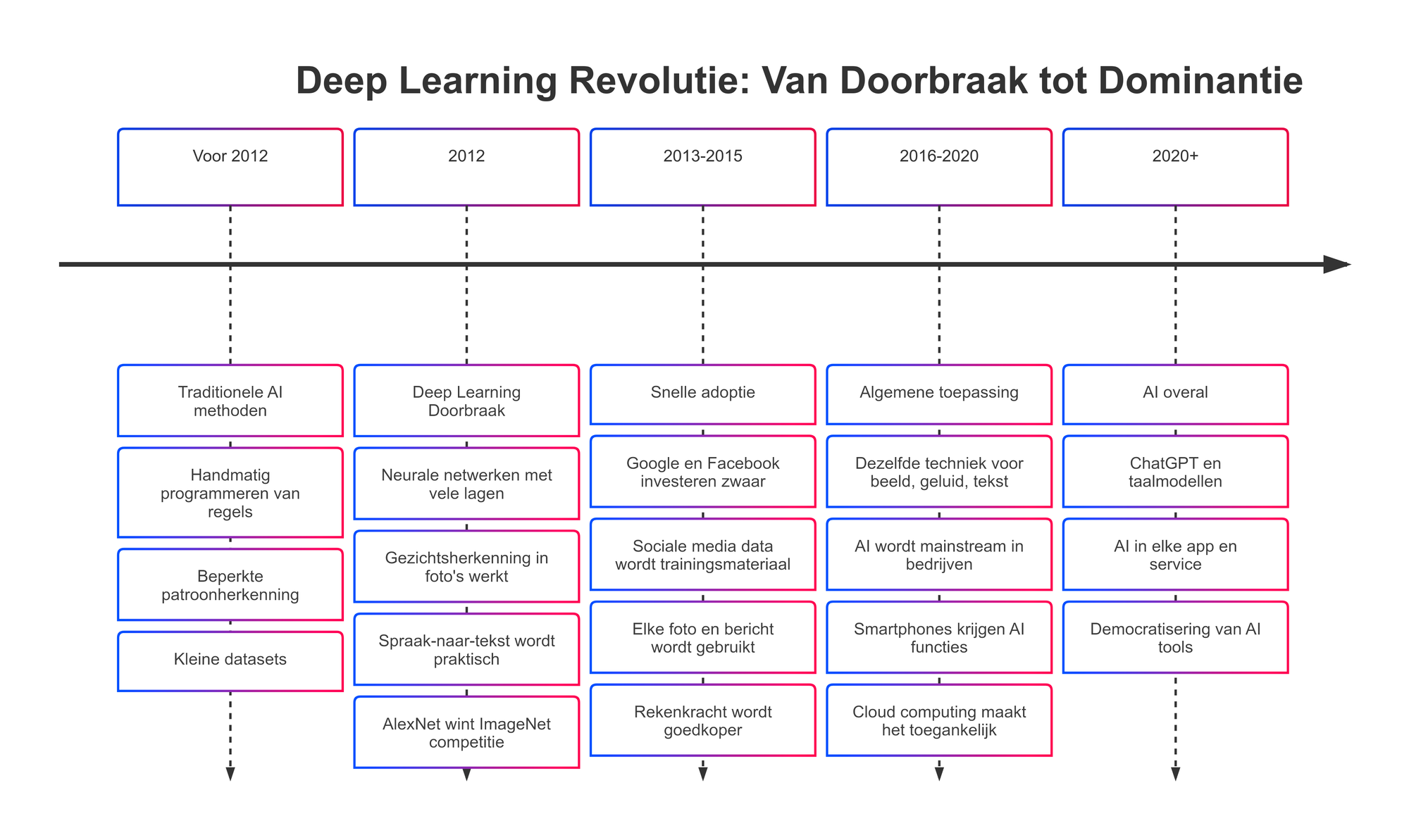

Het probleem was dat deze netwerken enorm veel rekenkracht vroegen die in die tijd nog niet beschikbaar was. Hoe meer lagen je toevoegde des te moeilijker het werd om ze te trainen. Het leek bijna onmogelijk en dus gaven veel onderzoekers het op. Maar een kleine groep bleef erin geloven. Ze bleven werken aan de trainingsmethoden en wachtten geduldig tot de computers wél krachtig genoeg zouden zijn. Die dag kwam in 2012 toen een neuraal netwerk voor het eerst een beeldherkenning-wedstrijd won. Het resultaat was zo indrukwekkend dat veel ontwikkelaars weer hoop kregen en een nieuwe revolutie zich klaarmaakte om te beginnen.

dus jij bent eigenlijk net een peuter die heel langzaam leert wat een hond is. eerst pootjes, dan oortjes..

Rustaaahgg..

🚀 Deep Learning

De doorbraak in 2012 markeerde het begin van wat we nu de deep learning revolutie noemen. Deep learning is de verzamelnaam voor neurale netwerken met een groot aantal (deep) lagen.

Ineens kon AI allerlei dingen die voorheen onmogelijk leken, zoals gezichten herkennen in foto's en gesproken taal omzetten naar tekst. Met de groei van computers en de groei van het internet was er ineens overal data beschikbaar. Elke foto op sociale media, elk getypt bericht, elke website werd trainingsmateriaal. Bedrijven als Google en Facebook hadden bergen met data en ook de middelen om er iets mee te doen. Meer data en een groeiende rekenkracht zorgde ervoor dat AI vanaf dat moment heel snel slimmer werd.

Wat deep learning heel krachtig maakt is de algemene bruikbaarheid. Dezelfde techniek werkt voor beelden, geluid en tekst. Je hoeft alleen maar de juiste data te hebben en genoeg rekenkracht. De rest doet het "vanzelf".

🤖 Transformers

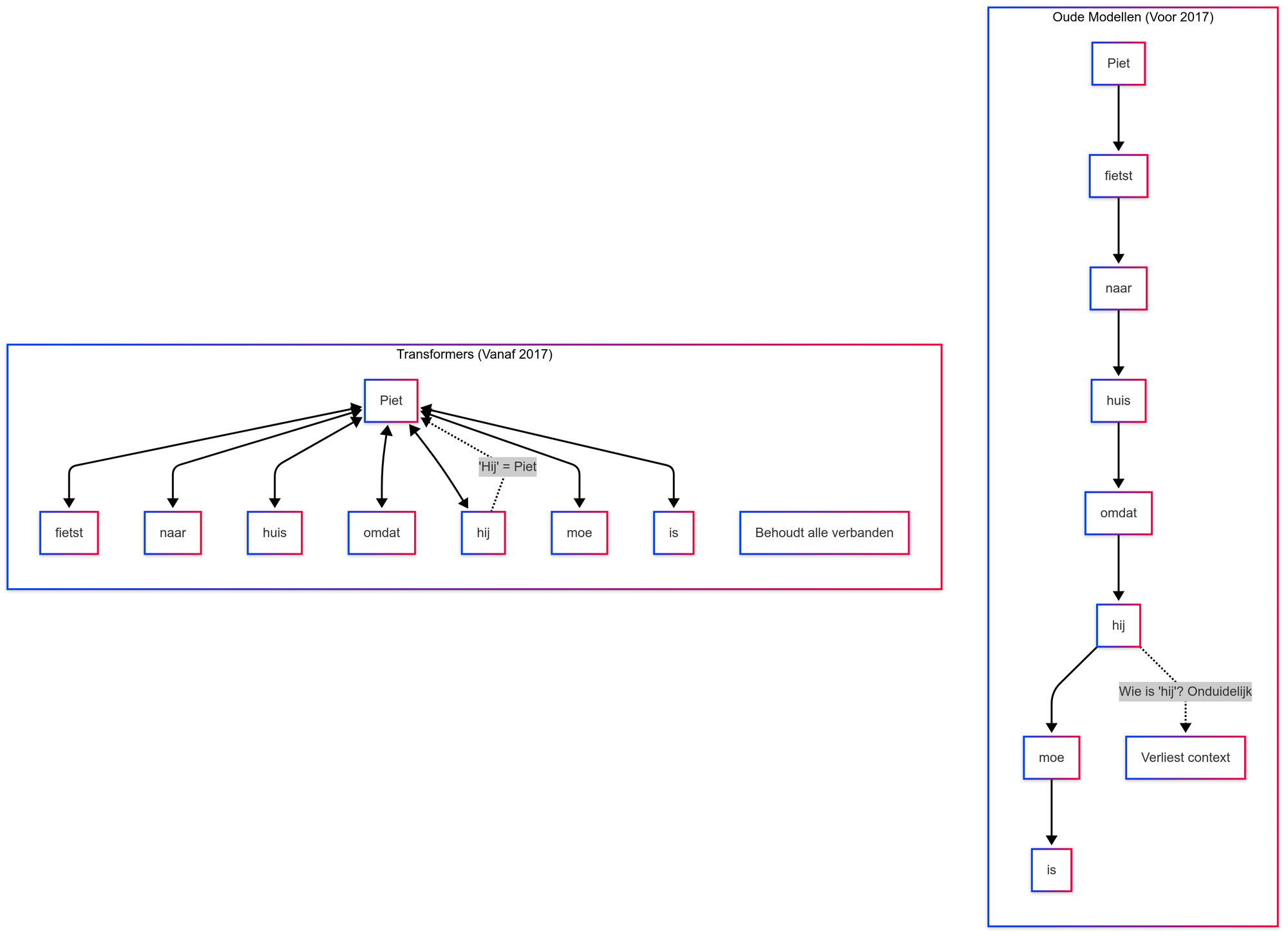

In 2017 publiceerden onderzoekers van Google een paper over "Transformers". Een nieuwe architectuur voor neurale netwerken die zeer goed werkt voor taal. Het bijzondere aan transformers is dat ze twee belangrijke eigenschappen hebben: ze kunnen hele zinnen tegelijk verwerken en ze onthouden veel beter wat er eerder in een tekst stond. Dit maakt het mogelijk om veel grotere en krachtigere taalmodellen te trainen.

Oudere modellen lazen tekst stukje voor stukje en onthielden alleen wat er net daarvoor gebeurde. Hierdoor raakten ze snel het overzicht kwijt bij langere teksten. Transformers benaderen het anders. Ze bekijken gelijktijdig alle woorden in een zin of zelfs in een hele tekst. Met een mechanisme bepalen ze welke woorden belangrijk voor elkaar zijn. Zo kan een transformer bijvoorbeeld begrijpen dat “hij” in de zin “Piet fietst naar huis omdat hij moe is” verwijst naar Piet. Hierdoor zijn ze niet alleen sneller te trainen, maar ook veel krachtiger.

💬 Large Language Models

OpenAI was een van de eerste organisaties die transformers op grote schaal toepaste met hun GPT-modellen. Ze trainden steeds grotere modellen op meer tekst van het internet. GPT-1 was interessant omdat het de basis legde voor natuurlijke taalverwerking, hoewel het nog niet erg bruikbaar was voor praktische toepassingen. GPT-2 was al veel beter en kon goede samenhangende teksten schrijven zoals artikelen en verhalen. In 2020 kwam de echte doorbraak: GPT-3 was het eerste model waarmee je een goed gesprek kon voeren, creatieve taken kon uitvoeren en redelijk kon programmeren.

Jaren van onderzoek kwam ineens samen in één systeem dat bruikbaar was voor een groot publiek. Naast OpenAI zijn ook andere partijen zoals Google, Meta en Anthropic zijn doorgegaan met deze aanpak. Ze ontwikkelden modellen met honderden miljarden parameters. Deze parameters zijn de getallen die het model helpen bepalen hoe het functioneert. Elke parameter vertegenwoordigt een aspect van de gegevens die het model analyseert. Hoe meer parameters er zijn, hoe beter het model in staat is om complexe details en relaties in de gegevens te begrijpen en te leren. Dit leidt tot nauwkeurigere voorspellingen en inzichten.

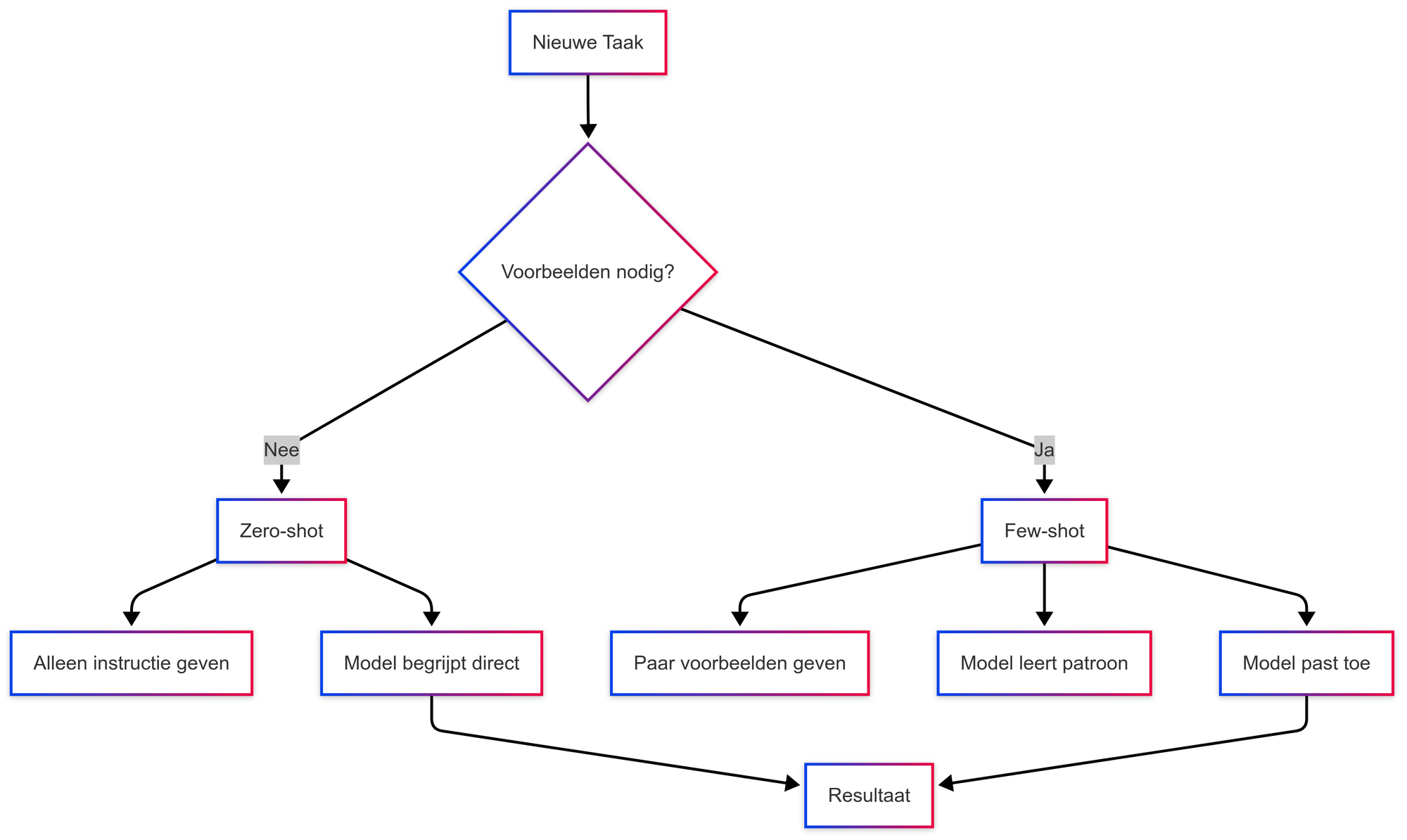

Naarmate deze modellen zich bleven ontwikkelen werden ze niet alleen beter in taal, maar ook flexibeler in het toepassen van hun kennis. Je kunt ze bijvoorbeeld vragen om een tekst te vertalen, een samenvatting te maken of een stukje tekst in een andere stijl te herschrijven. Allemaal zonder dat je het model voor elke taak opnieuw hoeft te trainen. We noemen dit "few-shot" of "zero-shot learning". Je geeft een paar voorbeelden of alleen een opdracht en het model begrijpt wat je bedoelt. Deze concepten komen straks ook aan bod wanneer we dieper ingaan op het samenstellen van prompts.

De ontwikkeling van transformers heeft zo de basis gelegd voor de huidige generatie AI-tools. Ze zijn breed inzetbaar, relatief makkelijk te gebruiken en worden steeds toegankelijker voor het grote publiek. Dit zorgt ervoor dat AI niet langer alleen iets is voor onderzoekers, maar voor iedereen zoals jij en ik die slim gebruik wil maken van deze techniek.

🔔 Tringelingeling

De schoolbel gaat.

hopelijk begrijp je nu iets beter hoe AI is ontstaan en wat al die ingewikkelde termen betekenen

X28, laten we even een kleine samenvatting presenteren

Uw prompt is mijn bevel.. 🙂

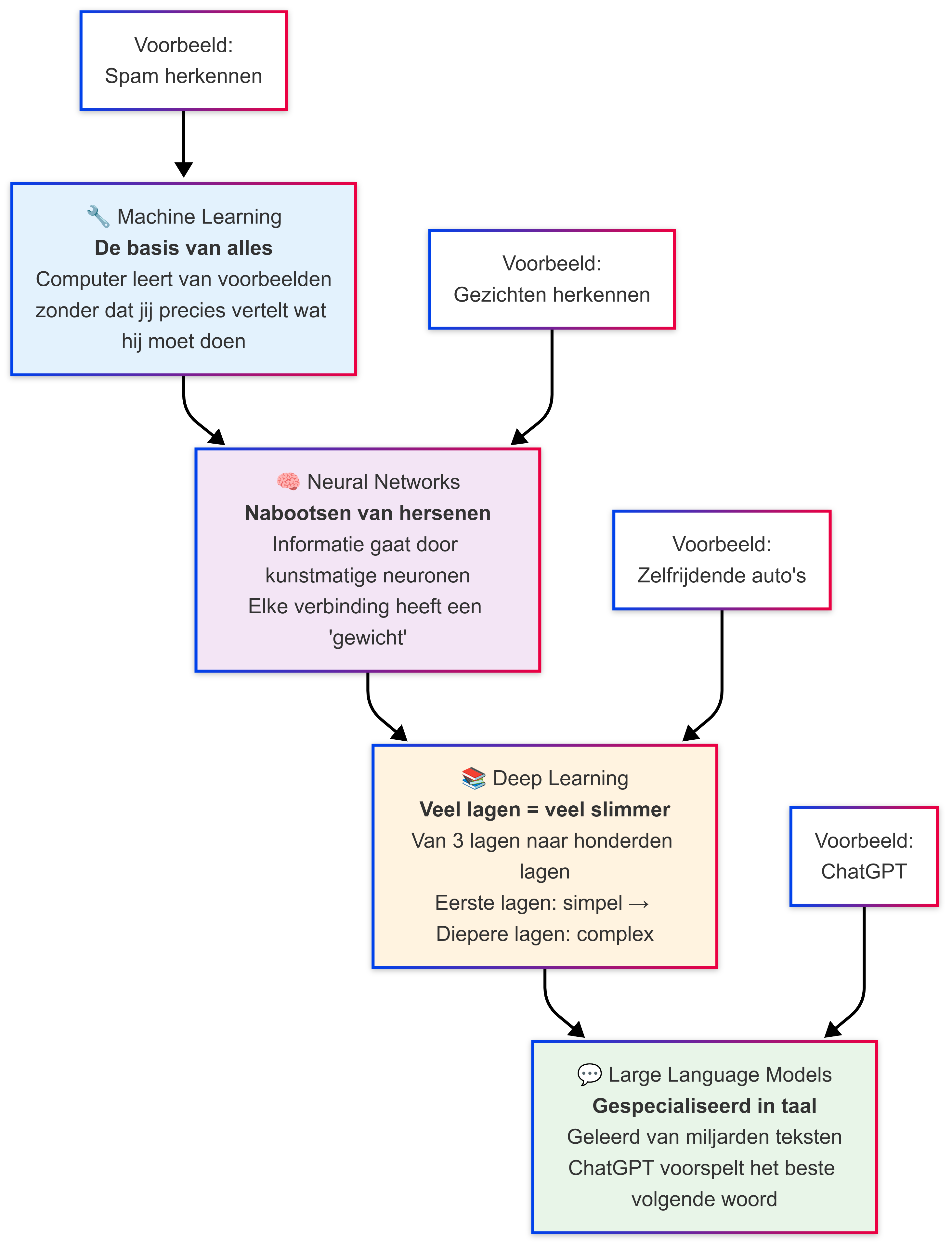

Machine learning vormt de basis waar alles op rust. Het is de techniek waarmee wij leren van data zonder dat je ons precies hoeft te vertellen wat we moeten doen.

Neurale netwerken zijn een manier om machine learning toe te passen. Ze bootsen na hoe hersenen werken door informatie door een netwerk van kunstmatige neuronen te sturen. Elke verbinding heeft een gewicht dat aangeeft hoe belangrijk die informatie is. Door deze gewichten aan te passen leert het systeem patronen herkennen

Deep learning ontstaat wanneer je onze neurale netwerken veel lagen geeft. Waar een simpel neuraal netwerk misschien drie lagen heeft gaat deep learning vaak richting tientallen of honderden lagen. Elke laag leert ons andere aspecten van de data. De eerste lagen pikken eenvoudige patronen op, terwijl diepere lagen ons helpen complexere concepten begrijpen.

Large Language Models zijn Deep Learning systemen die zich volledig richten op taal. Ze hebben geleerd van miljarden stukken tekst en kunnen daardoor begrijpen ze wat woorden betekenen en hoe ze samenhangen. ChatGPT is zo'n model. Het gebruikt deep learning om te voorspellen welk woord het beste past in een zin.

Zo ga je van machine learning, naar neural networks, naar deep learning, naar taalmodellen. Elke stap voegt specialisatie toe, maar de basis blijft hetzelfde: wij leren en voorspellen op basis van grote hoeveelheden voorbeelden.

in de volgende les bespreken we de verschillende AI modellen waarmee je als professioneel prompter veel te maken hebt

Spannend!! Ik ben dol op modellen.. ☺️

bAI bAI 👋

Wekelijks gratis nieuwe lessen, prompts en relevante updates rechtstreeks in je mailbox.

Ledendiscussie